Aspectos Técnicos Clave para Entrenar Algoritmos Avanzados de Redes Neuronales y Esquemas de Aprendizaje Automático

La fase de entrenamiento es crucial para el desarrollo de algoritmos avanzados de redes neuronales y esquemas de aprendizaje automático. Uno de los primeros aspectos a considerar es la correcta división del conjunto de datos en tres partes: entrenamiento, validación y prueba.

CIENCIA, TECNOLOGIA, IA, AI

Jairo A. Mejia R.

7/5/20244 min read

Selección y Preprocesamiento de Datos

El primer paso crítico en el entrenamiento de algoritmos avanzados de redes neuronales y esquemas de aprendizaje automático es la selección de un conjunto de datos adecuado y su preprocesamiento. Contar con datos limpios y bien etiquetados es esencial, ya que los algoritmos de aprendizaje automático dependen de la calidad de los datos para hacer predicciones precisas. Datos sucios o mal etiquetados pueden llevar a modelos que no performan adecuadamente, afectando la validez y robustez de los resultados obtenidos.

Uno de los desafíos más comunes en la preparación de datos es manejar los datos faltantes y ruidosos. Técnicas comunes como la imputación de valores faltantes, la eliminación de filas incompletas, y el uso de métodos estadísticos pueden ser útiles. Además, es importante identificar y mitigar el impacto de datos ruidosos. Esto puede implicar el uso de métodos de detección de valores atípicos y técnicas de suavizado para reducir el ruido presente en los datos.

La normalización y estandarización de los datos son pasos cruciales en el preprocesamiento. La normalización asegura que todas las características en el conjunto de datos tengan una escala similar, mejorando así la eficiencia y estabilidad del entrenamiento del algoritmo. La estandarización, por otro lado, transforma los datos para que tengan una media cero y una desviación estándar de uno, lo que puede ser particularmente beneficioso para algoritmos que asumen que los datos se distribuyen normalmente.

Para mejorar la diversidad del conjunto de datos de entrenamiento y asegurar que el modelo generalice bien a datos nuevos, se utilizan métodos de aumento de datos. Estas técnicas implican crear versiones modificadas del conjunto de datos existente, utilizando transformaciones como rotaciones, escalados, y adiciones de ruido. De esta forma, se enriquece el conjunto de datos sin necesidad de recopilar nuevos datos, lo que puede ser costoso y laborioso.

En resumen, la selección y preprocesamiento de datos son fases esenciales y detalladas que requieren atención minuciosa para construir modelos de aprendizaje automático robustos y efectivos. La calidad y tecnicidad en estas etapas pueden determinar el éxito o fracaso de los algoritmos en tareas de predicción y clasificación complejas.

Arquitectura de la Red y Modelos de Aprendizaje

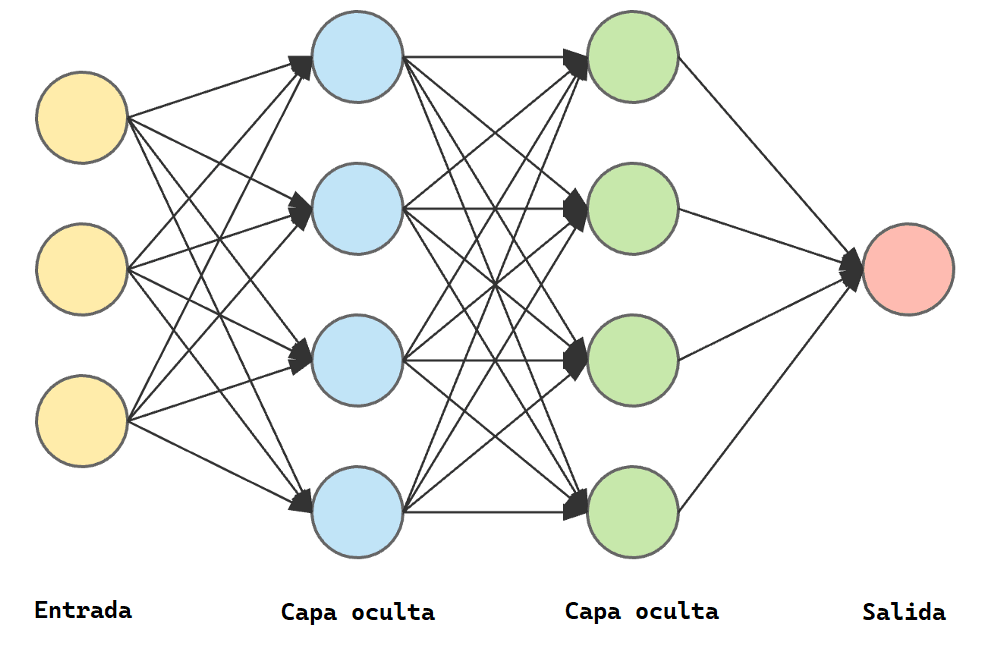

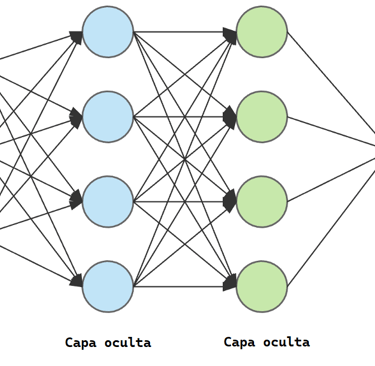

La arquitectura de la red y el modelo de aprendizaje que se elijan tienen un impacto significativo en el rendimiento de los algoritmos de redes neuronales. Existen diversas arquitecturas que abarcan una amplia gama de aplicaciones y retos específicos. Entre las más relevantes se encuentran las redes neuronales convolucionales (CNN), redes neuronales recurrentes (RNN) y redes densas o de alimentación hacia adelante.

Las redes neuronales convolucionales (CNN) son especialmente efectivas para tareas de reconocimiento de imágenes y procesamiento visual. Su capacidad para detectar y aprender patrones espaciales a diferentes niveles de abstracción es invaluable. Las capas convolucionales, junto con las capas de pooling y las funciones de activación no lineales (como ReLU), permiten a las CNNs generalizar bien en problemas complejos de visión por computadora.

Por otro lado, las redes neuronales recurrentes (RNN) están diseñadas para manejar datos secuenciales, siendo muy útiles en aplicaciones como la traducción automática, el procesamiento de lenguaje natural y el análisis de series temporales. Las RNN pueden recordar información a través de lapsos de tiempo gracias a su arquitectura de conexiones recurrentes. Sin embargo, sufren de problemas como el desvanecimiento del gradiente, lo que ha conducido al desarrollo de variantes como las Long Short-Term Memory (LSTM) y las Gated Recurrent Unit (GRU) para superar estas limitaciones.

Las redes densas, también conocidas como redes de alimentación hacia adelante, son la forma más básica de redes neuronales donde todas las neuronas de una capa están conectadas a todas las neuronas de la siguiente. Estas redes son robustas para una variedad de problemas generales y se emplean comúnmente cuando no se requiere una estructura específica de datos como en las secuencias o imágenes.

Además, es esencial aplicar técnicas de regularización como dropout y L2 regularization para prevenir el problema del sobreajuste, donde el modelo aprende demasiado bien el conjunto de entrenamiento pero falla en generalizar para nuevos datos. También, la elección de funciones de activación, tales como ReLU, Sigmoid y Tanh, influye en cómo la red captura las no linealidades en los datos. Finalmente, seleccionar una función de pérdida adecuada, como la entropía cruzada para clasificación o el error cuadrático medio para regresión, es crucial para optimizar el proceso de aprendizaje del modelo.

Técnicas de Entrenamiento y Optimización

La fase de entrenamiento es crucial para el desarrollo de algoritmos avanzados de redes neuronales y esquemas de aprendizaje automático. Uno de los primeros aspectos a considerar es la correcta división del conjunto de datos en tres partes: entrenamiento, validación y prueba. Esta segmentación asegura que el modelo no solo se ajuste bien a los datos de entrenamiento, sino que también generalice correctamente a nuevos datos no vistos.

En términos de optimización, los algoritmos más comunes incluyen el Descenso de Gradiente Estocástico (SGD), Adam y RMSprop. Estos algoritmos de optimización presentan distintas ventajas. Por ejemplo, el SGD es simple y eficiente, especialmente para grandes conjuntos de datos y modelos. Adam, una combinación de AdaGrad y RMSprop, adapta individualmente las tasas de aprendizaje para cada parámetro, acelerando la convergencia del modelo. Mientras tanto, RMSprop es utilizado principalmente en problemas de procesamiento de señales y series temporales debido a su capacidad para mantener una tasa de aprendizaje adaptable.

Ajustar correctamente los hiperparámetros, como la tasa de aprendizaje, el tamaño del batch y el número de épocas, es esencial para la eficiencia del entrenamiento. La tasa de aprendizaje controla la magnitud de la actualización de los pesos del modelo. Un valor demasiado alto puede conducir a una convergencia inestable, mientras un valor demasiado bajo puede hacer que el entrenamiento sea extremadamente lento. El tamaño del batch, por su parte, afecta el ruido en las actualizaciones de los parámetros y la estabilidad de la convergencia. Por último, el número de épocas determina cuántas veces el conjunto de datos de entrenamiento completo es utilizado para actualizar los parámetros del modelo.

Adicionalmente, herramientas y bibliotecas de software como TensorFlow y PyTorch facilitan la implementación y entrenamiento de modelos de aprendizaje automático. Estas bibliotecas ofrecen una gran cantidad de recursos preconfigurados y opciones de personalización que permiten a los desarrolladores ajustar modelos con mayor precisión. TensorFlow proporciona una estructura robusta para la creación de gráficos computacionales, mientras que PyTorch destaca por su enfoque dinámico y facilidad de uso.

Nuestros canales

Mapa